[[422244]]葡京娱乐百家乐

本文转载自微信公众号「大数据时候与数仓」,作家西贝。转载本文请磋商大数据时候与数仓公众号。

Spark是一个快速的大数据处理引擎,在执行的出产环境中,应用十分平凡。现在,Spark仍然是大数据开发相等进击的一个器具,是以在口试的过程中,Spark也会是被要点西宾的对象。对于入门者而言,濒临蕃昌的Spark干系主意,一时会难以厘清脉络,对于使用Spark开发的同学而言,偶然候也会对这些主意感到暗昧。本文主要梳理了几个对于Spark的比较进击的几个主意,在口试的过程中如若被问到Spark干系的问题,具体不错从以下几个方面伸开即可,但愿对你有所匡助。本文主要包括以下内容:

运行架构 运行经由 实践模式 驱动顺序 分享变量 宽依赖窄依赖 捏久化 分区 轮廓实践案例 构成

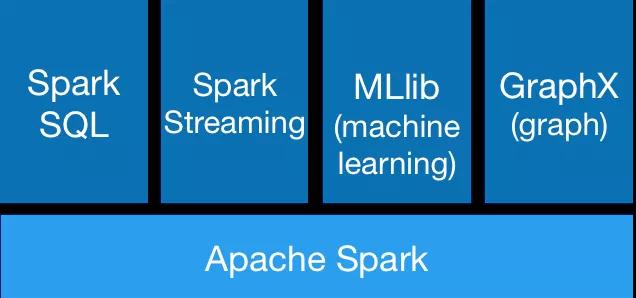

Spark栈包括SQL和DataFrames,MLlib机器学习, GraphX和SparkStreaming。用户不错在归拢个应用顺序中无缝组合使用这些库。

皇冠客服飞机:@seo3687 架构

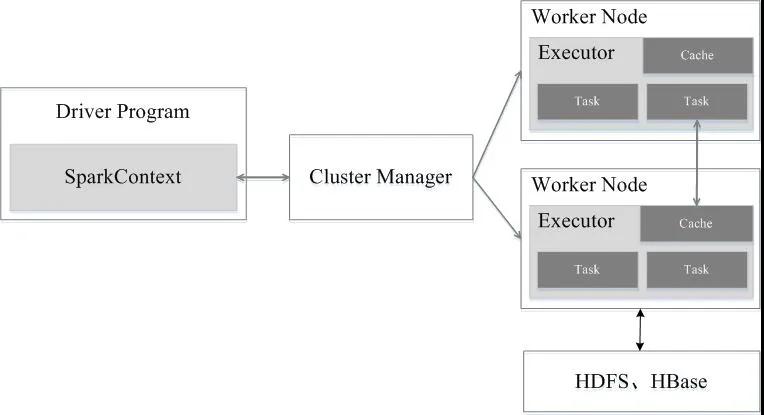

Spark运行架构包括集群资源惩办器(Cluster Manager)、运行功课任务的责任节点(Worker Node)、每个应用的任务猖狂节点(Driver)和每个责任节点上肃肃具体任务的实践程度(Executor)。其中,集群资源惩办器不错是Spark自带的资源惩办器,也不错是YARN或Mesos等资源惩办框架。

运行经由

运行经由

与Spark比拟,MapReduce具有以下裂缝:

抒发智商有限 磁盘IO支出大 延长高 任务之间的衔战役及IO支出 在前一个任求实践完成之前,其他任务就无法启动,难以胜任复杂、多阶段的计较任务与MapReduce比拟,Spark具有以下优点:具体包括两个方面

皇冠信用盘代理 一是行使多线程来实践具体的任务(Hadoop MapReduce吸收的是程度模子),减少任务的启动支出; 二是Executor中有一个BlockManager存储模块,会将内存和磁盘共同看成存储开采,当需要多轮迭代计较时,不错将中间终结存储到这个存储模块里,下次需要时,就不错径直读该存储模块里的数据,而不需要读写到HDFS等文献系统里,因而灵验减少了IO支出;或者在交互式查询场景下,事先将表缓存到该存储系统上,从而不错耕作读写IO性能。 驱动顺序(Driver)和Executor运行main函数的驱动顺序程度位于集群中的一个节点上,肃肃三件事:

保养联系 Spark 应用顺序的信息。 反应用户的顺序或输入。 跨Executor分析、分派和退换功课。驱动顺序程度是填塞必要的——它是 Spark 应用顺序的中枢,并在应用顺序的生命周期内保养总计干系信息。

重庆时时彩棋牌Executor肃肃执行实践驱动顺序分派给他们的任务。这意味着每个Executor只肃肃两件事:

实践驱动顺序分派给它的代码。 向Driver节点陈述该Executor的计较景况 分区为了让每个 executor 并行实践责任,Spark 将数据解析成称为partitions 的块。分区是位于集群中一台物理机器上的行的麇集。Dataframe 的分区暗示数据在实践时间如安在机器集群中物理分散。

如若你有一个分区,即使你稀有千个Executor,Spark 的并行度也只好一个。如若你有许多分区但只好一个实践器,Spark 仍然只好一个并行度,因为只好一个计较资源。

实践模式:Client VS Cluster VS Local实践模式约略在运行应用顺序时笃定Driver和Executor的物理位置。

有三种模式可供选用:

集群模式(Cluster)。 客户端模式(Client)。 土产货模式(Local)。集群模式 可能是运行 Spark 应用顺序最常见的形貌。在集群模式下,用户将预编译的代码提交给集群惩办器。除了启动Executor以外,集群惩办器会在集群内的责任节点(work)上启动驱动顺序(Driver)程度。这意味着集群惩办器肃肃惩办与 Spark 应用顺序干系的总计程度。

客户端模式 与集群模式着实相易,只是 Spark 驱动顺序保留在提交应用顺序的客户端节点上。这意味着客户端机器肃肃保养 Spark driver 程度,集群惩办器保养 executor 程度。频频将这个节点称之为网要害点。

土产货模式不错被以为是在你的计较机上运行一个顺序,spark 会在归拢个 JVM 中运行驱动顺序和实践顺序。

皇冠体育hg86a

RDD VS DataFrame VS DataSetRDD

一个RDD是一个分散式对象麇集,其执行是一个只读的、分区的纪录麇集。每个RDD不错分红多个分区,不同的分区保存在不同的集群节点上(具体如下图所示)。RDD是一种高度受限的分享内存模子,即RDD是只读的分区纪录麇集,是以也就不可对其进行修改。只可通过两种形貌创建RDD,一种是基于物理存储的数据创建RDD,另一种是通过在其他RDD上作用改革操作(transformation,比如map、filter、join等)得到新的RDD。

基于内存RDD是位于内存中的对象麇集。RDD不错存储在内存、磁盘或者内存加磁盘中,可是,Spark之是以速率快,是基于这么一个事实:数据存储在内存中,而且每个算子不会从磁盘上索求数据。

分区分区是对逻辑数据集离别红不同的沉静部分,分区是分散式系统性能优化的一种时候妙技,不错减少收集流量传输,将相易的key的元素分散在相易的分区中不错减少shuffle带来的影响。RDD被分红了多个分区,这些分区分散在集群中的不同节点。

强类型RDD中的数据是强类型的,当创建RDD的时候,总计的元素齐是相易的类型,该类型依赖于数据集的数据类型。

懒加载Spark的改革操作是懒加载模式,这就意味着只好在实践了action(比如count、collect等)操作之后,才会去实践一些列的算子操作。

不可修改RDD一朝被创建,就不可被修改。只可从一个RDD改革成另外一个RDD。

并行化RDD是不错被并行操作的,由于RDD是分区的,每个分区分散在不同的机器上,是以每个分区不错被并行操作。

捏久化由于RDD是懒加载的,只好action操作才会导致RDD的改革操作被实践,进而创建出相对应的RDD。对于一些被相同使用的RDD,不错对其进行捏久化操作(比如将其保存在内存或磁盘中,Spark支撑多种捏久化政策),从而耕作计较效果。

DataFrame

DataFrame代表一个不可变的分散式数据麇集,其中枢标的是闪开发者濒临数据处理时,只关注要作念什么,而无须关注奈何去作念,将一些优化的责任交由Spark框架自己行止理。DataFrame是具有Schema信息的,也即是说不错被看作念具有字段称号和类型的数据,访佛于关系型数据库中的表,可是底层作念了许多的优化。创建了DataFrame之后,就不错使用SQL进行数据处理。

用户不错从多种数据源中构造DataFrame,举例:结构化数据文献,Hive中的表,外部数据库或现存RDD。DataFrame API支撑Scala,Java,Python和R,在Scala和Java中,row类型的DataSet代表DataFrame,即Dataset[Row]等同于DataFrame。

DataSet

鑫皇冠DataSet是Spark 1.6中添加的新接口,是DataFrame的推广,它具有RDD的优点(强类型输入,支撑浩瀚的lambda函数)以及Spark SQL的优化实践引擎的优点。不错通过JVM对象构建DataSet,然后使用函数改革(map,flatMap,filter)。值得隆重的是,Dataset API在Scala和 Java中可用,欧博真人博彩Python不支撑Dataset API。

另外,DataSet API不错减少内存的使用,由于Spark框架知说念DataSet的数据结构,因此在捏久化DataSet时不错从简许多的内存空间。

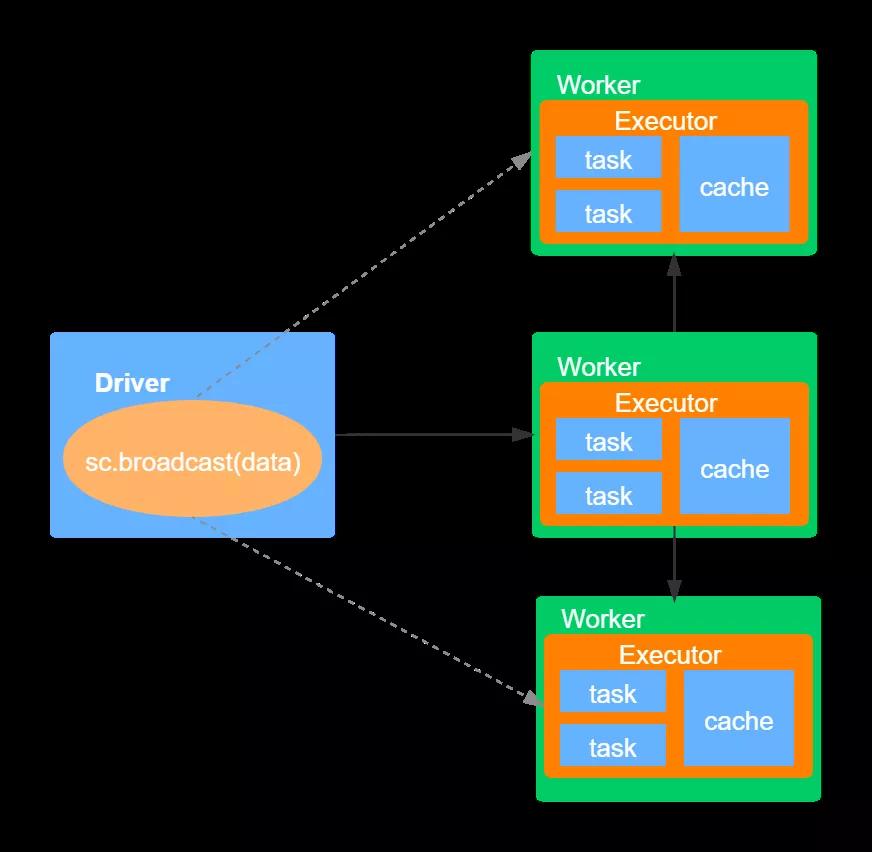

分享变量Spark提供了两种类型的分享变量:播送变量和累加器。播送变量(Broadcast variables)是一个只读的变量,而且在每个节点齐保存一份副本,而不需要在集群中发送数据。累加器(Accumulators)不错将总计任务的数据累加到一个分享终结中。

播送变量

播送变量允许用户在集群中分享一个不可变的值,该分享的、不可变的值被捏策划到集群的每台节点上。频频在需要将一份少许据集(比如维表)复制到集群中的每台节点时使用,比如日记分析的应用,web日记频频只包含pageId,而每个page的标题保存在一张表中,如若要分析日记(比如哪些page被探访的最多),则需要将两者join在沿途,这时就不错使用播送变量,将该表播送到集群的每个节点。具体如下图所示:

如上图,当先Driver将序列化对象分割成小的数据库,然后将这些数据块存储在Driver节点的BlockManager上。当ececutor中实践具体的task时,每个executor当先尝试从我方地方节点的BlockManager索求数据,如若之前一经索求的该播送变量的值,就径直使用它。如若莫得找到,则会向资料的Driver或者其他的Executor中索求播送变量的值,一朝赢得该值,就将其存储在我方节点的BlockManager中。这种机制不错幸免Driver端向多个executor发送数据而酿成的性能瓶颈。

累加器

累加器(Accumulator)是Spark提供的另外一个分享变量,与播送变量不同,累加器是不错被修改的,是可变的。每个transformation会将修改的累加器值传输到Driver节点,累加器不错完结一个累加的功能,访佛于一个计数器。Spark自己支撑数字类型的累加器,用户也不错自界说累加器的类型。

宽依赖和窄依赖RDD中不同的操作会使得不同RDD中的分区产不同的依赖,主要有两种依赖:宽依赖和窄依赖。宽依赖是指一个父RDD的一个分区对应一个子RDD的多个分区,窄依赖是指一个父RDD的分区对应与一个子RDD的分区,或者多个父RDD的分区对应一个子RDD分区。

充值窄依赖会被离别到归拢个stage中,这么不错以管说念的口头迭代实践。宽依赖所依赖的分区一般有多个,是以需要跨节点传输数据。安静灾方面看,两种依赖的计较终结规复的形貌是不同的,窄依赖只需要规复父RDD丢失的分区即可,而宽依赖则需要有计划规复总计父RDD丢失的分区。

DAGScheduler会将Job的RDD离别到不同的stage中,并构建一个stage的依赖关系,即DAG。这么离别的标的是既不错保险莫得依赖关系的stage不错并行实践,又不错保证存在依赖关系的stage规章实践。stage主要分为两种类型,一种是ShuffleMapStage,另一种是ResultStage。其中ShuffleMapStage是属于上游的stage,而ResulStage属于最卑劣的stage,这意味着上游的stage先实践,终末实践ResultStage。

捏久化形貌

在Spark中,RDD吸收惰性求值的机制,每次碰到action操作,齐会从新启动实践计较。每次调用action操作,齐会触发一次从新启动的计较。对于需要被相同使用的RDD,spark支撑对其进行捏久化,通过调用persist()或者cache()方法即可完结RDD的捏策划。通过捏久化机制不错幸免相同计较带来的支出。值得隆重的是,当调用捏久化的方法时,只是对该RDD标记为了捏久化,需要比及第一次实践action操作之后,才会把计较终结进行捏久化。捏久化后的RDD将会被保留在计较节点的内存中被后头的举止操作相同使用。

Spark提供的两个捏久化方法的主要区别是:cache()方法默许使用的是内存级别,其底层调用的是persist()方法。

捏久化级别的选用

Spark提供的捏久化存储级别是在内存使用与CPU效果之间作念衡量,频频保举底下的选用形貌:

如若内存不错容纳RDD,不错使用默许的捏久化级别,即MEMORY_ONLY。这是CPU最灵验果的选用,不错使作用在RDD上的算子尽可能第快速实践。 如若内存不够用,不错尝试使用MEMORY_ONLY_SER,使用一个快速的序列化库不错从简许多空间,比如 Kryo 。tips:在一些shuffle算子中,比如reduceByKey,即便莫得显性调用persist方法,Spark也会自动将中间终结进行捏久化,这么作念的标的是幸免在shuffle时间发生故障而酿成再行计较通盘输入。即便如斯,如故保举对需要被相同使用的RDD进行捏久化处理。

coalesce VS repartitionrepartition算法对数据进行了shuffle操作,并创建了大小极度的数据分区。coalesce操作合并现存分区以幸免shuffle,除此以外coalesce操作仅能用于减少分区,不可用于增多分区。

值得隆重的是:使用coalesce在减少分区时,并莫得对所稀有据进行了移动,只是是在蓝本分区的基础之上进行了合并费力,是以效果较高,可是可能会引起数据歪斜。

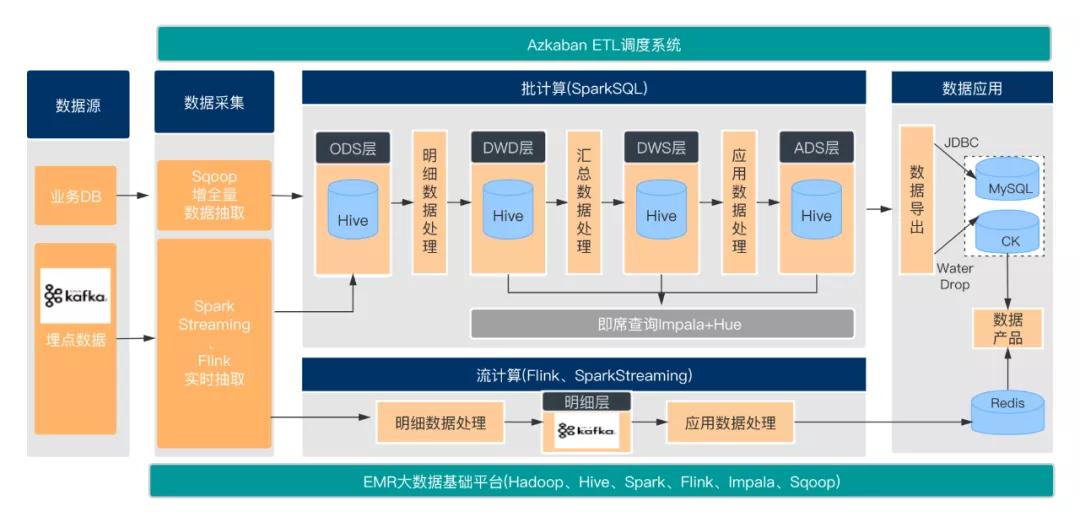

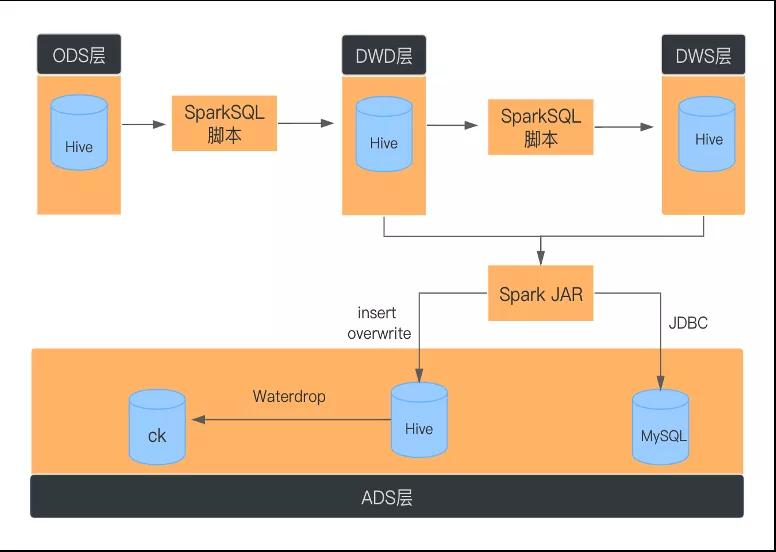

轮廓案例一种数仓时候架构

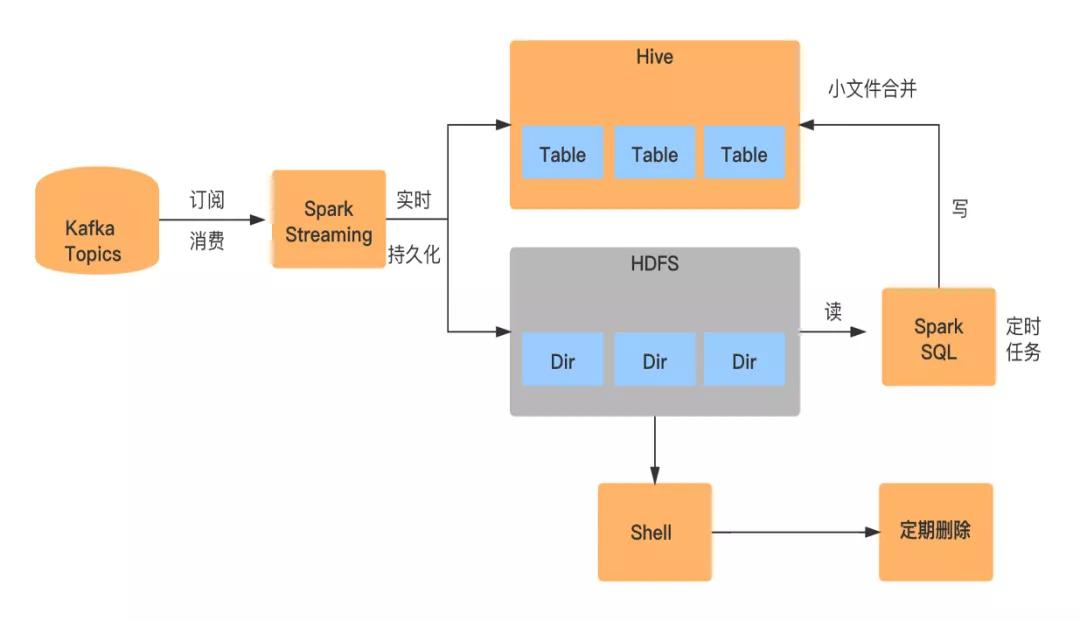

SparkStreaming及时同步

SparkStreaming浮滥kafka埋点数据

数据写入:将贯通的数据同期写入HDFS上的某个临时目次下及Hive表对应的分区目次下

皇冠代理在竞技比赛中,运动员的体力、技能和经验是非常重要的,但是运气也是不可忽视的因素。在皇冠体育,您可以通过各种方式提高您的胜率,从而获得更多的胜利和奖励。 小文献合并:由于是及时数据抽取,是以会生成多量的小文献,小文献的生成取决于SparkStreaming的Batch Interval,比如一分钟一个batch,那么一分钟就会生成一个小文献

基于SparkSQL的批处理

SparkStreaming数据输出是At Least Once,可能会存在数据相同。在ODS层到DWD层进行明细数据处理时,需要对数据使用row_number去重。

近日,在中国花样滑冰双人滑运动员注册名单公示中,国家队运动员彭程的注册单位变更为“北京市冬季运动管理中心”,并改为与老将王磊搭档。昨天,记者来到北京花滑队驻地,见到了这对新组合。两人目前已经完成节目编排,将在8月的俱乐部联赛中正式亮相。

JDBC写入MySQL数据量大时,需要对数据进行重分区,而且为DataSet分区级别建造市欢,吸收批量提交的形貌。

使用DISTRIBUTE BY子句幸免生成多量小文献spark.sql.shuffle.partitions的默许值为200,会导致以下问题

对于较小的数据,200是一个过大的选用,由于退换支出,频频会导致处理速率变慢,同期会酿成小文献的产生。 对于大数据集,200很小,无法灵验行使集群中的资源使用 DISTRIBUTE BY cast( rand * N as int) 这里的N是指具体终末落地生成若干个文献数。

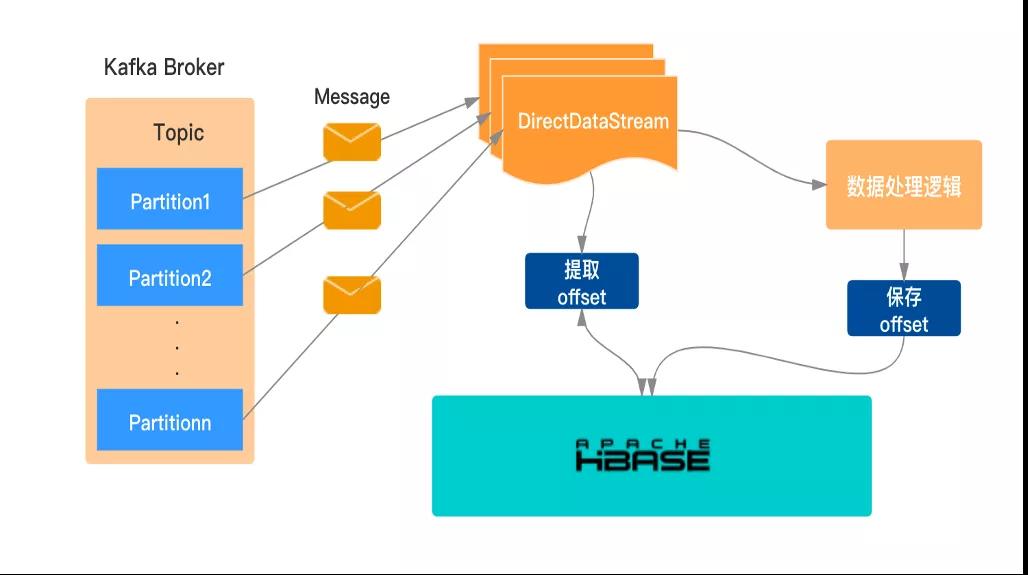

手动保养offset至HBase

当功课发生故障或重启时,要保险从刻下的浮滥位点行止理数据,单纯的依靠SparkStreaming自己的机制是不太理思,出产环境中频频借助手动惩办来保养kafka的offset。

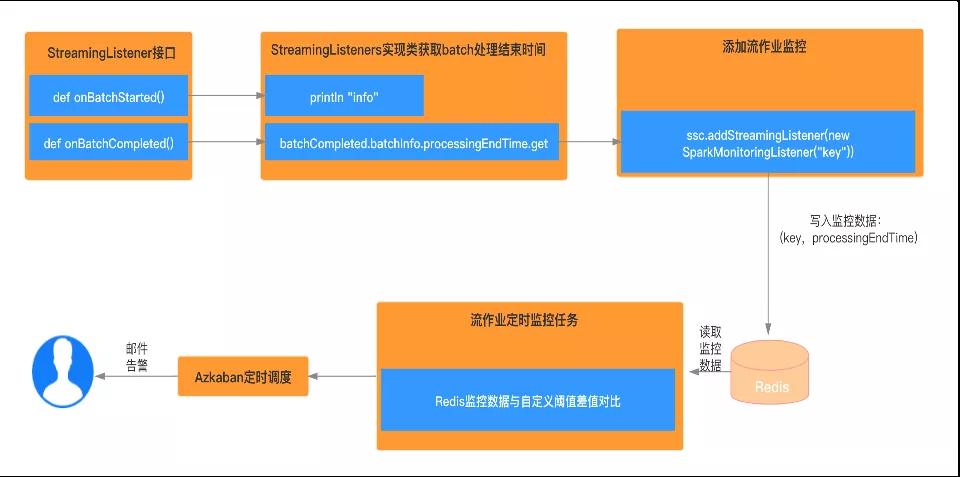

流应用监控告警

葡京娱乐百家乐